英伟达推出新款AI芯片H200 英伟达发布最强AI芯片H200

作者:chunzhi 发布时间:2023-11-14英伟达推出新款AI芯片H200,英伟达发布最强AI芯片H200

在全球算力荒的情况下,AI芯片巨头英伟达加速算力竞赛。当地时间11月13日,英伟达宣布推出新一代人工智能芯片H200,称其是目前世界“最强”的AI芯片。

H200此次升级主要体现在带宽更高、容量更大的内存,能以每秒4。8TB的速度提供141GB的内存,而其目前最先进的H100的带宽和容量分别为3。35TB和80GB。这将提升大模型在推理方面的表现,并有助于提升高性能计算应用的计算能力。

英伟达预计,H200将在明年二季度开始发货,谷歌、微软、甲骨文等科技巨头将会率先实现首批部署。但毫无疑问,H200将无缘中国市场。

英伟达最强AI芯片,推理性能提升90%

H200是英伟达当前用于训练最先进大语言模型H100芯片的升级产品,它基于英伟达Hopper架构,配备具有先进内存的NVIDIA H200 Tensor Core GPU,可处理生成式AI和高性能计算工作负载的大量数据。

H200还是英伟达第一款使用HBM3e内存的芯片。HBM3E是最新一代的内存规格,可以满足用于AI存储必备的速度,也在发热控制和客户使用便利性等所有方面达到全球最高水平,存储巨头SK海力士、美光等都在布局。

借助内存速度更快、容量更大的HBM3e,英伟达H200以每秒4。8TB的速度提供141GB的内存,与A100相比,容量几乎是其两倍,带宽也提升大43%,从而加速生成式AI和大语言模型,提高高性能计算(HPC)的工作负载。

内存带宽对HPC应用程序至关重要,因为它可以实现更快的数据传输,减少复杂的处理瓶颈。英伟达表示,对模拟、科学研究和人工智能等内存密集型HPC应用,H200更高的内存带宽可确保高效地访问和操作数据,与CPU相比速度最多可加快110倍。

据英伟达测算,借助H200,1750亿参数的GPT-3的推理速度是H100的1。6倍,700亿参数的Llama2大模型的推理速度则是H100的1。9倍,而高性能仿真计算速度则达到A100的2倍。总体来看,H200由于更强大的内存,更适用于推理,在其用于推理或生成问题答案时,性能较H100提高60%至90%。

此外,H200和H100两款芯片可以互相兼容。英伟达称,这意味着已经在使用H100进行训练的人工智能公司,不需要改变他们的服务器系统或软件来适应H200。

英伟达大规模与高性能计算副总裁Ian Buck表示,要利用生成式人工智能和高性能计算应用创造智能,必须使用大型、快速的GPU显存,来高速高效地处理海量数据。借助H200,业界领先的端到端人工智能超算平台可以更快解决一些世界上最重要的挑战。

除H200之外,英伟达还发布了HGX H200 平台,这是使用较新加速器的8路 HGX H100 的更新版本。而当H200与英伟达Grace CPU搭配使用时,就组成了性能更为强大的超级计算机GH200 Grace Hopper,其专为大型HPC和AI应用的计算而设计。

英伟达称,在H200加持之下,GH200超级芯片将为全球各地的超级计算中心提供总计约200 Exaflops的AI算力,用以推动科学创新。德国尤里希超级计算中心、筑波大学和东京大学共同成立的日本先进高性能计算联合中心、德克萨斯高级计算中心、伊利诺伊大学香槟分校的美国国家超级计算应用中心等都将利用GH200超级芯片提升计算能力。

此外,英伟达还公布了未来的产品路线图,将使用同一构架设计三款芯片,在明年和后年会继续推出B100和X100,性能有望进一步提升。

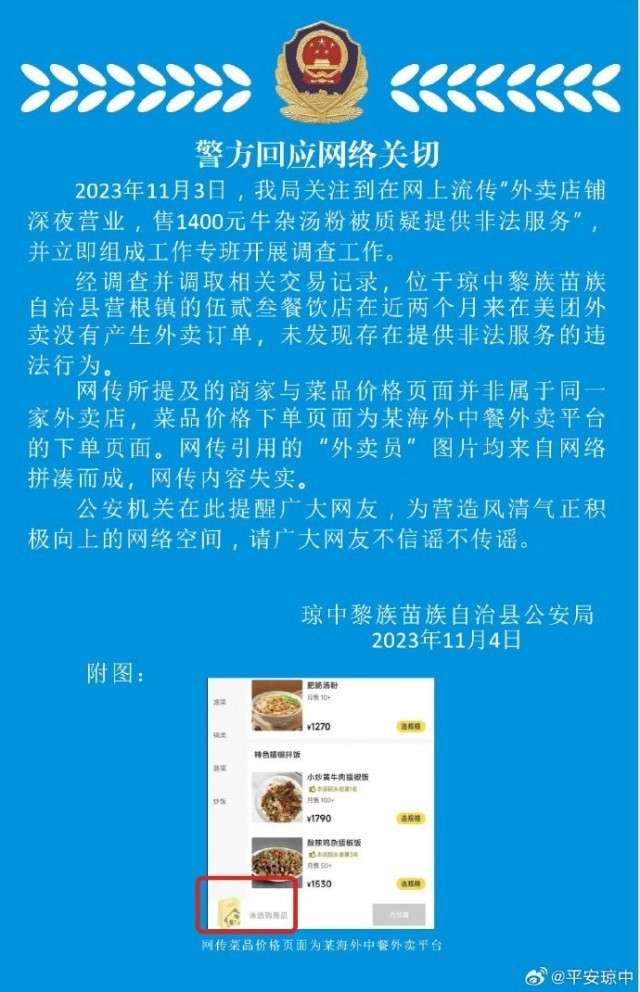

辟谣深夜牛杂汤服务

辟谣深夜牛杂汤服务 硬卧车厢吃饭吃出满

硬卧车厢吃饭吃出满 中使馆:在以中企正组

中使馆:在以中企正组 中使馆建议在以公民

中使馆建议在以公民 王音棋新闻联播首位

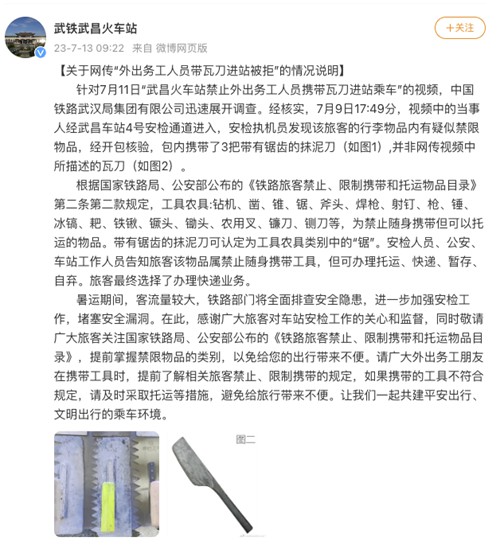

王音棋新闻联播首位 工人带瓦刀进站被拒

工人带瓦刀进站被拒 中南大学一校友向母

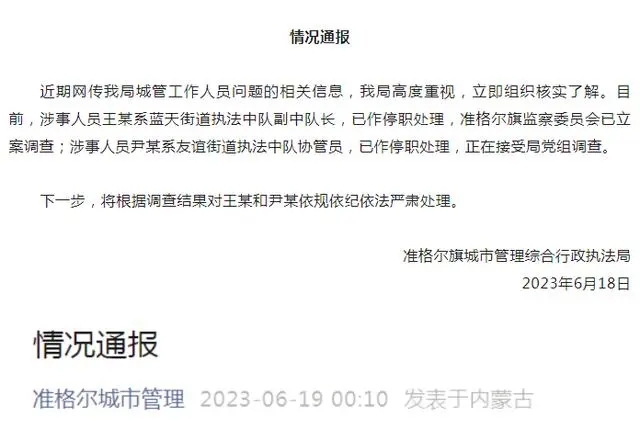

中南大学一校友向母 城管干部出轨女下属

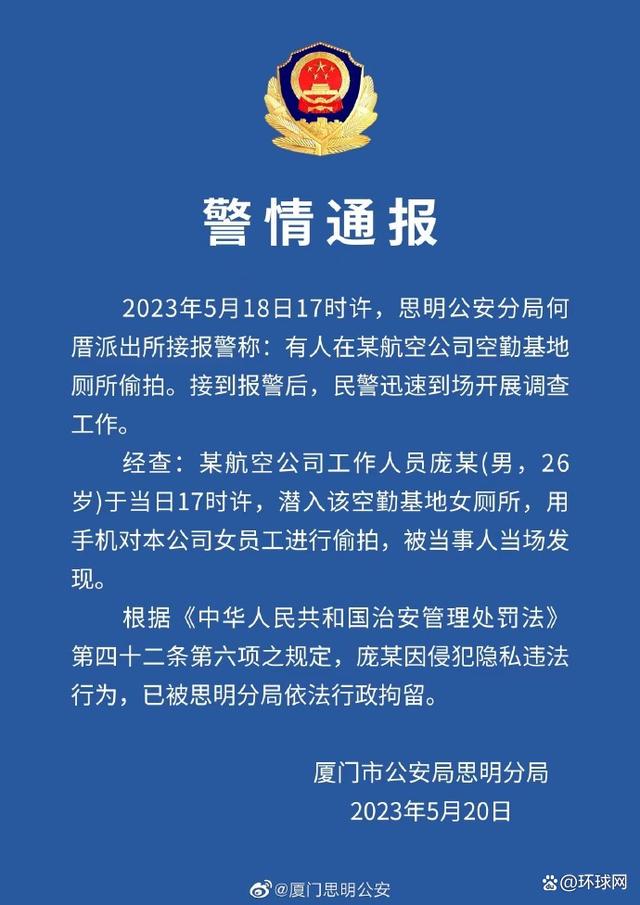

城管干部出轨女下属 厦航员工在女厕偷拍

厦航员工在女厕偷拍 一家三口五一出游被

一家三口五一出游被