安全政策遭质疑 OpenAI解散AGI团队 OpenAI解散AGI团队

作者:chunzhi 发布时间:2024-10-25布伦戴奇于 2018 年加入 OpenAI,最初担任研究科学家,后来成为该公司的政策研究主管。在加入 OpenAI 之前,布伦戴奇曾担任牛津大学人类未来研究所的研究员。

在 AGI 准备团队中,Brundage 特别关注ChatGPT等语言生成系统的负责任部署。他还领导了其他项目,包括 OpenAI 的外部红队计划及其首份记录 AI 模型能力和局限性的“系统卡”报告。

近年来,OpenAI 的一些前员工和董事会成员指责该公司将商业产品放在首位,而牺牲了 AI 安全。在 X 的帖子中,Brundage 敦促 OpenAI 员工畅所欲言,讨论公司如何做得更好。

他写道:有些人对我说,他们对我的离开感到难过,并且感谢我在任期间经常愿意提出顾虑或问题……OpenAI 面临着许多艰难的决定,如果我们屈服于集体思维,就无法做出正确的决定。

由于对公司发展方向的分歧,OpenAI 最近几周一直在裁员。首席技术官 Mira Murati、首席研究官 Bob McGrew 和研究副总裁 Barret Zoph 于 9 月底宣布 辞职。著名研究科学家 Andrej Karpathy 于 2 月离开 OpenAI;几个月后,OpenAI 联合创始人兼前首席科学家 Ilya Sutskever 和前安全负责人 Jan Leike也辞职了。8 月,联合创始人 John Schulman 表示将离开 OpenAI。而公司总裁 Greg Brockman 正在延长休假。

对于 OpenAI 来说,这是相当不愉快的一天。

周三上午,该公司成为《纽约时报》对前 OpenAI 研究员苏吉尔·巴拉吉 (Suchir Balaji) 的专题报道的主角。

巴拉吉表示,他离开公司是因为他不再想为他认为会给社会带来更多伤害而非好处的技术做出贡献。巴拉吉还指责 OpenAI 未经许可使用受知识产权保护的数据训练其模型,侵犯了版权——其他人在集体诉讼中对该组织提出了这一指控。

他在个人博客中写道,他认为该公司没有遵守美国版权法。越来越多的人认为,这家科技巨头的数据收集业务建立在不可靠的(甚至明显不合法的)法律基础之上,他就是其中的一员。

苏希尔·巴拉吉 (Suchir Balaji) 最近告诉《纽约时报》 : 如果你相信我所相信的东西,你就必须离开公司。

25 岁的加州大学伯克利分校毕业生巴拉吉于 2020 年加入 OpenAI,随后继续从事 GPT-4 工作。

他说,他最初对从事人工智能行业感兴趣是因为他认为这项技术可以用于解决无法解决的问题,比如治愈疾病和阻止衰老。

巴拉吉在 OpenAI 工作了四年,今年夏天离开了公司。现在,巴拉吉说,他看到这项技术被用于他不赞同的事情,并认为人工智能公司“正在破坏个人、企业和互联网服务的商业可行性,而正是这些数字数据创造了用于训练这些人工智能系统的数字数据”,《纽约时报》写道。

本周,巴拉吉在他的个人网站上发布了一篇文章,他认为 OpenAI 违反了版权法。在文章中,他试图展示人工智能系统训练数据集中有多少受版权保护的信息最终进入了模型的输出。

巴拉吉从分析中得出的结论是,ChatGPT 的输出不符合“合理使用”的标准,即允许在未经版权所有者许可的情况下有限使用受版权保护的材料的法律标准。

巴拉吉后来在谈到人工智能商业模式引发的法律问题时告诉《纽约时报》:解决这一切的唯一出路就是监管。

Gizmodo 联系了 OpenAI 以征求意见。在提供给《纽约时报》的一份声明中,这家科技公司对 Balaji 的批评提出了如下反驳:我们使用公开数据构建我们的人工智能模型,以公平使用和相关原则保护的方式,并得到长期和广泛接受的法律先例的支持。我们认为这一原则对创造者公平,对创新者必要,对美国竞争力至关重要。

值得注意的是,《纽约时报》目前正在起诉 OpenAI未经许可使用其版权材料。

《纽约时报》声称,该公司及其合作伙伴微软曾使用该报的数百万篇新闻文章来训练其算法,该算法此后一直试图争夺同一市场。

该报并非孤例。OpenAI 目前遭到众多名人、艺术家、作家和程序员的起诉,他们都声称自己的作品被该公司的数据窃取算法窃取。

起诉 OpenAI 的其他知名人士/组织包括Sarah Silverman、Ta-Nahisi Coates、George RR MArtin、Jonathan Franzen、John Grisham、调查报道中心、The Intercept、多家报纸(包括《丹佛邮报》和《芝加哥论坛报》)以及各种 YouTube 用户等。

尽管公众既困惑又不感兴趣,但批评人工智能行业商业模式的人却越来越多。名人、技术伦理学家和法律专家都对这个行业持怀疑态度,因为它的权力和影响力不断增长,同时给世界带来了新的法律和社会难题。

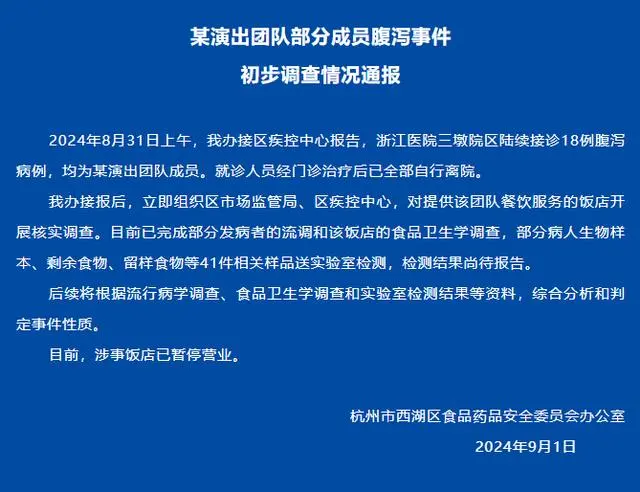

刘谦团队被曝集体食

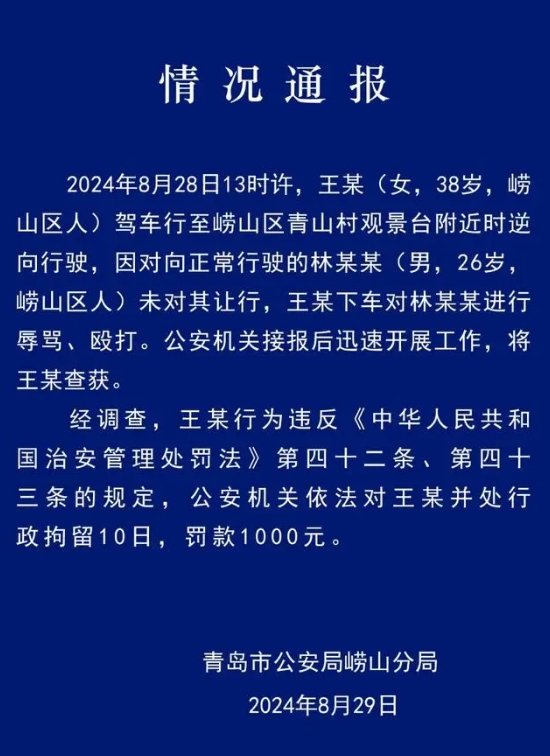

刘谦团队被曝集体食 逆行打人的路虎女是

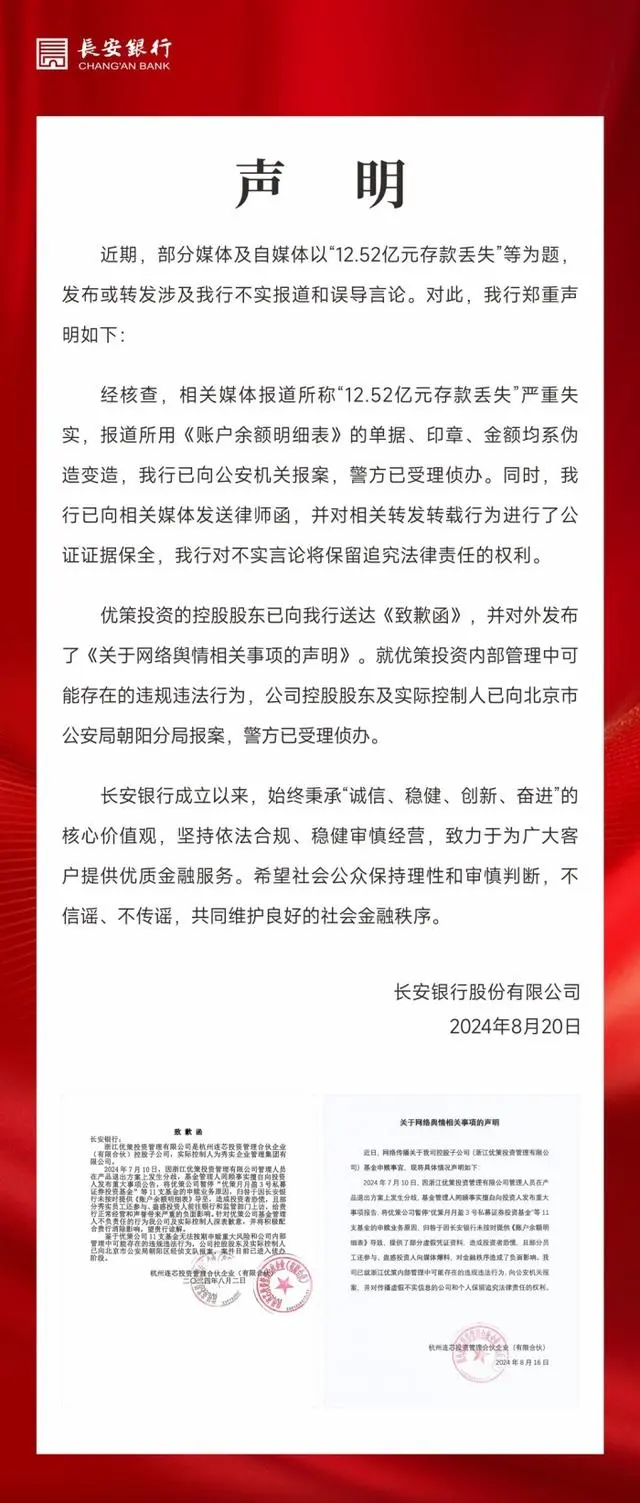

逆行打人的路虎女是 长安银行回应“12.5

长安银行回应“12.5 湖南8个村子因暴雨失

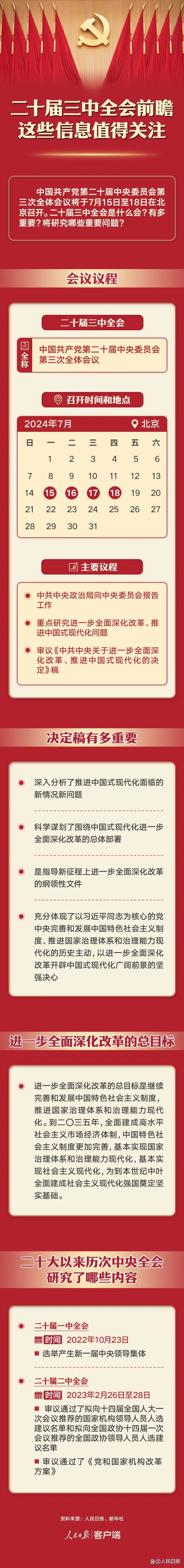

湖南8个村子因暴雨失 二十届三中全会前瞻

二十届三中全会前瞻 河南一商户发现欠燃

河南一商户发现欠燃 形似外星生物巨型尸

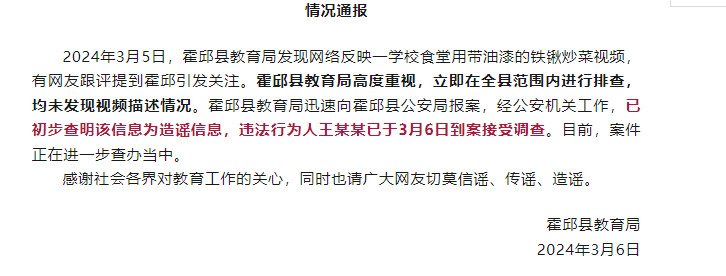

形似外星生物巨型尸 学校食堂用带油漆铁

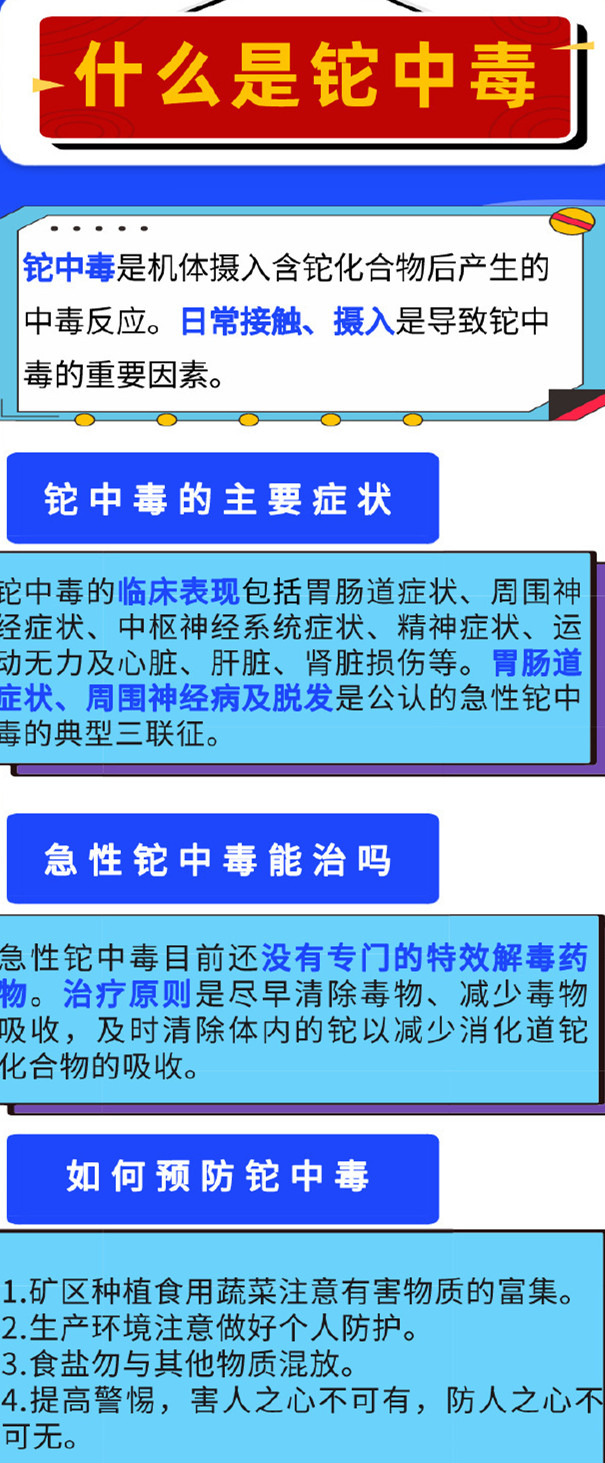

学校食堂用带油漆铁 什么是铊中毒?铊中

什么是铊中毒?铊中 辟谣深夜牛杂汤服务

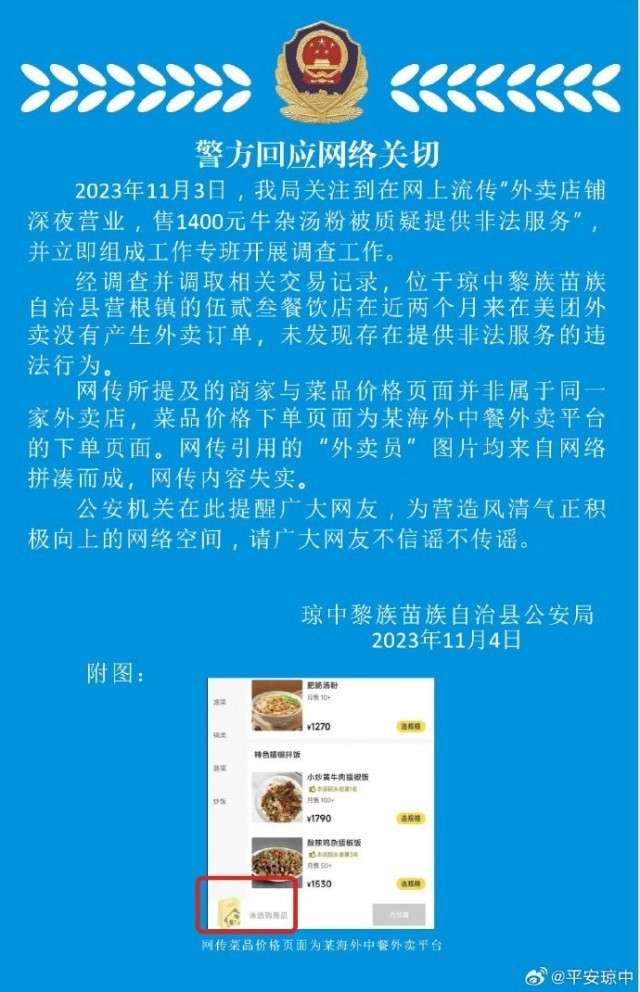

辟谣深夜牛杂汤服务